从之前还不太成熟的刘强东京东卖书,到现在几乎区分不出来的数字人带货,随着AI技术的发展,数字人的应用日益广泛,今天我们就一起来看看数字人到底是怎么个事。

一、数字人技术概述与分类体系1.1 数字人技术定义与发展历程

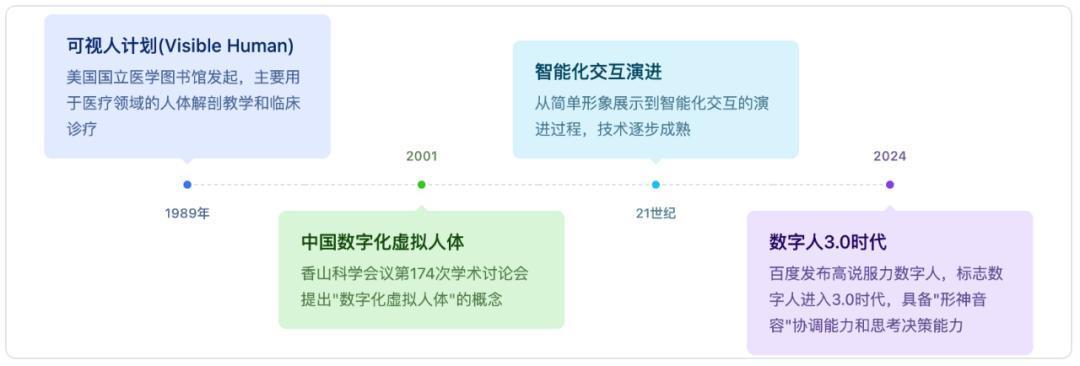

一、数字人技术概述与分类体系1.1 数字人技术定义与发展历程数字人技术定义:数字人技术是融合人工智能、计算机图形学、语音合成、动作捕捉等多学科技术的综合性应用,旨在创建具有人类外观、行为和智能交互能力的虚拟形象。

根据中国人工智能产业发展联盟的定义,虚拟数字人应具备三个核心特征:

拥有人的外观、具有特定的相貌性别和性格等人物特征拥有人的行为、具有用语言面部表情和肢体动作表达的能力拥有人的思想、具有识别外界环境并能与人交流互动的能力发展历程

1.2 数字人技术分类体系

1.2 数字人技术分类体系数字人技术可按照多个维度进行分类,形成了较为完整的技术分类体系。

按技术维度分类:

根据中国人工智能产业发展联盟的“五横两纵”技术架构,

“五横” 是指用于数字人制作、交互的五大技术模块,即人物生成、人物表达、合成显示、识别感知、分析决策等模块;

“两纵” 是指 2D、3D 数字人,2D 数字人和 3D 数字人在技术架构方面基本一致,区别在于 3D 数字人需要额外使用三维建模技术生成数字形象,信息维度增加,所需的计算量更大。

按驱动方式分类:

数字人可分为真人驱动型、AI 驱动型和混合驱动型。真人驱动通过动作捕捉 (Mocap) 与语音识别由真人操控;AI 驱动通过语音合成、表情驱动、自然语言处理自动生成内容与交互;混合驱动部分由 AI 驱动,关键动作 / 内容由真人操控修正。

按技术实现方式分类:

2D数字人:包括基于Unity2D和Live2D等技术的实现方式3D数字人:包括基于Unity3D、UnrealEngine等游戏引擎的实现方式语音驱动型数字人:通过语音识别、语音合成技术驱动面部表情和肢体动作AI生成型数字人:基于深度学习模型如StyleGAN、扩散模型等生成数字人形象和动作按应用场景分类:

可分为信息助手型、泛娱乐型、企业级服务型等,其中企业级服务数字人包括直播数字人、智能客服、虚拟主播、保险代理人、AI 数字员工、虚拟导游、虚拟讲解员等。

1.3 技术架构与核心能力数字人的核心技术架构采用分层设计理念,从底层硬件支撑到上层应用服务形成完整的技术栈。基础层为虚拟数字人提供基础软硬件支撑,硬件包括显示设备、光学器件、传感器、芯片等,基础软件包括建模软件、渲染引擎。

核心技术能力包括:

视觉感知能力:通过计算机视觉技术实现面部识别、表情分析、姿态估计等功能语音交互能力:集成语音识别(ASR)、语音合成(TTS)和自然语言处理(NLP)技术,实现语音驱动的交互体验动作生成能力:通过动作捕捉技术或AI算法生成自然的面部表情和肢体动作智能决策能力:基于深度学习模型和知识库实现智能对话和决策实时渲染能力:支持高保真的实时渲染,确保视觉效果的真实性技术发展趋势:2024-2025 年,数字人技术在算法优化、硬件成本降低、应用场景拓展等方面取得重大突破。字节跳动开源的 LatentSync1.5 技术通过优化算法与训练数据集,显著提升了唇形同步精度,同时降低了对高性能硬件的依赖,使得数字人技术能够在消费级设备上流畅运行。京东科技通过语音合成大模型 LiveTTS 及通用数字人大模型 LiveHuman,将单个数字人的生产成本从数万元压缩至两位数,相比传统真人拍摄模式,成本降幅超过 90%。

二、数字人技术实现方式与技术原理2D 数字人技术在实现方式上主要包括 Unity 2D 和 Live2D 两种主流技术路径。Unity 2D 是 Unity Technologies 开发的多平台游戏引擎,在全球所有游戏中有超过一半都是使用 Unity 创作的,其在 2D 数字人制作中具有广泛应用。Live2D 则是专门用于 2D 数字人制作的专业软件,能够以一张原画实现 “2D 立体表现” 的效果。

Unity 2D 技术实现原理:Unity 2D 采用传统的 2D 精灵 (Sprite) 动画技术,通过将人物形象分解为多个独立的部件,如头部、身体、四肢等,然后通过骨骼动画系统控制这些部件的运动和变形。Unity 2D 支持 2D 物理引擎、粒子系统、光照效果等高级特性,能够创建出具有丰富视觉效果的 2D 数字人。

Live2D 技术实现原理:Live2D 的核心技术是将原画进行精细拆分,拆分的越细,能动部位就越多、效果越灵活。通过 Live2D 中的弯曲和旋转变形器来实现动态效果,模型文件主要由纹理、骨骼、变形器等组件构成。Live2D 的技术优势在于能够以较低的资源消耗实现丰富的面部表情和肢体动作,特别适合于二次元风格的数字人制作。

2D 数字人渲染技术:2D 数字人渲染主要采用传统的 2D 渲染管线,包括顶点着色器、片段着色器等核心组件。通过高质量的材质和纹理贴图,提升数字人的视觉效果;通过光照与阴影计算,增强数字人的立体感和真实感。现代 2D 数字人渲染技术还支持实时阴影、粒子效果、后期处理等高级特性。

2. 3D 数字人技术实现3D 数字人技术相比 2D 数字人在技术复杂度和视觉效果上都有显著提升,主要采用 Unity 3D、Unreal Engine 等专业游戏引擎进行开发。

3D 建模技术:3D 数字人的制作首先需要通过三维建模技术创建人物的几何模型。主流的 3D 建模软件包括 Blender、Cinema 4D、3ds Max、Maya、Substance Painter、Modo 等。建模过程包括创建基础网格、细节雕刻、拓扑优化、UV 展开、纹理绘制等多个环节。

3D 骨骼绑定与动画系统:3D 数字人需要通过骨骼绑定技术将几何模型与虚拟骨骼系统连接,然后通过动画系统控制骨骼的运动和变形。现代 3D 引擎支持复杂的 IK (反向动力学) 系统、物理模拟、动作捕捉数据导入等高级功能。

实时渲染技术:3D数字人的实时渲染是技术实现的关键环节,主要包括以下几个方面:渲染引擎架构:现代3D渲染引擎采用基于物理的渲染(PBR)技术,结合实时光线追踪与可编程着色器,提升纹理细节与光影真实感,渲染帧率可达60fps以上。材质与纹理系统:通过高质量的材质和纹理贴图,包括基础颜色、法线贴图、粗糙度贴图、金属度贴图等,实现逼真的表面效果。光照与阴影技术:引入实时光线追踪与路径追踪技术,通过智能采样策略(如自适应重要性采样)提升渲染效率,减少计算冗余,在保证图像质量的前提下,将渲染时间控制在毫秒级。性能优化技术:采用轻量化引擎如OpenAvatarChat的LiteAvatar,可在RTX3060显卡上实现4K级30FPS实时渲染。其采用的高斯泼溅(GaussianSplatting)技术,比传统网格渲染快3倍,确保交互流畅不卡顿。Unreal Engine 在 3D 数字人中的应用:Unreal Engine 是 Epic Games 开发的跨平台游戏引擎,近年来在数字人制作领域得到广泛应用。通过 Unreal Engine,开发者可以利用其强大的 3D 建模、动画、物理模拟和渲染功能来制作高质量的数字人角色。Unreal Engine 的 MetaHuman Creator 工具能够创建高保真度的数字人,支持实时面部和身体动画。

3. 语音驱动型数字人技术原理语音驱动型数字人技术通过分析语音信号来驱动数字人的面部表情和肢体动作,实现语音与视觉的同步交互。该技术的核心在于建立语音特征与面部动作之间的映射关系。

语音信号处理技术:

音频特征提取:从原始音频到梅尔频谱(MFCC)的转化是基础。系统会对音频信号进行分帧处理,然后提取信号中的特征信息,例如梅尔频率倒谱系数(MFCC)、线性预测倒谱系数(LPCC)等。音素分割与识别:精准的音素分割算法是后续嘴型驱动准确性的保障。音素(Phoneme)与视位(Viseme)并非一一对应,如多个音素可能对应同一口型,音素-视位映射库的构建至关重要。声学模型构建:声学模型用于将语音的声学特征与相应的音素对应起来,语言模型用于估计句子的可能性,从而辅助识别结果的解码。口型同步技术原理:

视位驱动方法:视位(Viseme)是指与某一音位相对应的嘴、舌头、下颚等可视发音器官所处的状态。不同发音对应不同的口型,通过建立音素到视位的映射关系,实现语音驱动的口型动画。深度学习模型:通过搭建深度网络模型(DNN、CNN、RNN等),学习语音和口型/表情系数的映射关系。现代方法采用分层音频驱动视觉合成模块,将人脸细致地划分为嘴唇、表情和姿态三个区域,分别学习这三个区域与音频的对齐关系。实时驱动技术:NVIDIA开源的Audio2Face模型能够深度分析音频中的音素,精准捕捉微小的肌肉运动,生成与任何语言都高度匹配的口型。该技术会分析音频的语调、节奏和音量,并从中推断出说话者的情感,驱动一整套面部肌肉的联动。多模态语音驱动技术:现代语音驱动型数字人不仅实现口型同步,还能够根据语音的情感、韵律等特征生成相应的面部表情和肢体动作。阿里达摩院推出的 EchoMimic V2 是一款基于语音驱动的肖像动画生成工具,不仅可以让虚拟人物口型同步,还能添加头部与身体动作,让 AI 形象更加生动。

4. AI 生成型数字人技术原理AI 生成型数字人技术基于深度学习模型自动生成数字人的形象、表情和动作,代表了数字人技术的最新发展方向。

生成对抗网络 (GAN) 技术:

GAN基本原理:生成对抗网络由生成器(Generator)和判别器(Discriminator)组成,通过两者之间的对抗训练,生成器能够学习到真实人像数据的分布,从而生成高质量的数字人像。StyleGAN技术:StyleGAN是NVIDIA于2019年提出的生成对抗网络改进模型,在图像生成质量、训练稳定性和可控性方面取得显著突破。StyleGAN2的核心贡献是style-based生成,将latentvector映射到”风格向量”(stylevector),控制图像的不同层次(比如低层次控制颜色、纹理,高层次控制脸型、发型)。StyleGAN3技术突破:StyleGAN3通过改进的生成器架构与傅里叶特征输入,解决了纹理黏连问题。自适应实例归一化(AdaIN)层实现风格解耦,噪声输入的频域约束消除纹理震荡。实验数据显示,在1024×1024分辨率下,StyleGAN3相比前代模型将特征解耦度提升37%。神经辐射场 (NeRF) 技术:

eRF基本原理:神经辐射场(NeRF)技术通过将场景表示为连续的体密度和颜色函数,能够从多角度图像中重建出高保真的3D场景。在数字人制作中,NeRF技术能够实现超写实数字人形象生成与复刻。动态NeRF技术:最新的动态NeRF技术能够处理动态场景,实现数字人的动作生成和表情变化。通过时空联合建模,能够生成具有时间连续性的数字人动画。扩散模型技术:

扩散模型原理:扩散模型(DiffusionModels)通过在数据上逐步添加高斯噪声,然后学习去噪过程来生成新的数据样本。在数字人生成中,扩散模型能够以噪声迭代生成逼真细节(如皱纹、发丝)。DiT技术:DiT(基于Transformer架构的扩散模型)通过联合建模突破分辨率与复杂场景限制,使数字人具备实时交互、情感驱动与跨模态一致性。多模态生成技术:

文本到数字人生成:通过文本描述生成对应的数字人形象,如百度的文心一格、阿里的通义千问等大模型都具备文本生成数字人的能力。图像到数字人生成:基于单张或多张图像生成可动的数字人模型,如阿里通义开源发布的LHM可驱动超写实3D数字人生成模型,可单图秒级生成超写实3D数字人。视频驱动数字人:通过输入视频来驱动数字人的动作和表情,实现动作迁移和表情克隆。5. 多模态驱动型数字人技术实现多模态驱动型数字人技术整合语音、视觉、手势等多种交互方式,使数字人能够以更自然、高效的方式与用户互动。该技术的核心在于多模态信息的融合处理和协同驱动。

多模态感知技术:

视觉感知:通过RGB-D摄像头(如IntelRealSenseD455)实现毫米级动作捕捉与深度信息获取,结合面部识别技术实时捕捉用户的表情变化。语音感知:通过骨传导麦克风(如索尼EX3)实现高质量的语音采集,结合语音识别技术理解用户的语音指令。生理信号感知:通过生物传感器监测用户的心率、皮肤电反应等生理信号,结合情感计算技术分析用户的情绪状态。多模态融合技术架构:

分层处理架构:基于多模态交互的虚拟人系统通过整合视觉、听觉、触觉等多维数据通道,构建了分层处理架构。底层负责原始数据采集和预处理,中层负责特征提取和模式识别,顶层负责决策和响应生成。情感计算模块:集成OpenFace与iMotionsSDK,通过微表情分析(眼睑运动频率、嘴角曲率)和语音韵律(基频波动、停顿间隔)构建情感向量,实现对用户情绪状态的精准识别。多模态对齐技术:通过时间同步和特征对齐,确保不同模态信息的一致性。时钟同步算法是解决音画延迟的关键,通过精确的时间戳同步,将延迟控制在50ms以内。实时交互技术:

智能决策系统:基于多模态输入分析,通过自然语言处理(NLP)技术解析文本情感,情绪强度影响动作幅度(如愤怒时动作急促)和语音合成参数(如悲伤时语速放缓)。动作生成技术:基于语音中的情感、韵律以及文本语义信息,极速匹配出动作。虚拟人所有表情都是语义贯穿的,达到和动作、语义的整体一致。基于动作表征抽取技术,能极速生成数字人的表情和动作,让交互更流畅。跨模态生成技术:MIDAS多模态交互式数字人合成技术通过对标准大型语言模型(LLM)进行最小化修改,接受包括音频、姿态和文本在内的多模态条件编码,并输出空间和语义上连贯的表示来指导扩散头去噪过程。6. 技术对比与选择策略不同类型的数字人技术在应用场景、技术复杂度、成本效益等方面存在显著差异,选择合适的技术方案需要综合考虑多个因素。

技术选择策略建议:

成本优先场景:对于预算有限的应用场景,建议选择2D数字人技术或基于模板的3D数字人方案。京东科技通过技术创新将单个数字人的生产成本从数万元压缩至两位数,为中小企业提供了经济可行的解决方案。效果优先场景:对于需要高保真视觉效果的应用,如虚拟偶像、影视制作等,建议选择基于UnrealEngine的3D数字人技术或AI生成型数字人技术。交互优先场景:对于需要复杂交互能力的应用,如智能客服、教育培训等,建议选择语音驱动型或多模态驱动型数字人技术。技术发展趋势:随着AI技术的快速发展,AI生成型和多模态驱动型数字人将成为未来的主流技术方向。2025年,数字人将像水电一样渗透生活,极低的成本和不输真人的效果很有可能让它成为企业尝试拥抱大模型和应用大模型最好的入口之一。三、总结回顾过去的历史:

蒸汽机来了,纺织工变成机械师;

Photoshop 来了,修图师变成视觉设计师;

那么这次数字人来了,谁又会变成谁呢?

本文由 @AI Online 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

股票配资哪个平台是正规的提示:文章来自网络,不代表本站观点。